2018苹果WWDC发布会,你想知道的AI技术都在这里!

原创: Robot Li AI全球总部

苹果粉的2018苹果WWDC发布会

6月5日凌晨,2018苹果WWDC发布会,在世界苹果粉期盼目光下拉开了序幕。

没能守住现场直播的朋友,可以看这里。

大会现场Style很苹果

如果你是买买买的苹果粉,这次的WWDC发布会恐怕要让你失望了。

号称苹果史上最“软”发布会,几乎没有硬件产品更新,唯一的硬件产品就是“彩虹表带”。

彩虹表带

不得不说,这根表带我很喜欢,甚至冲动想去买一个。

虽然没有太多硬件更新,但发布了两个与AI技术相关的应用:一个是Siri,另一个就是图片管理。

Siri是苹果公司在其产品应用的一项智能语音控制功能。

Siri变身为一台智能化机器人,利用Siri用户可以通过手机读短信、介绍餐厅、询问天气、语音设置闹钟等。

应用一:Siri更AI了

不知道有没有像我这样的人?没事的时候总喜欢跟Siri有一搭没一搭的聊天。

Siri的回答真让人捉急,真怀疑Siri是不是人工智能的?

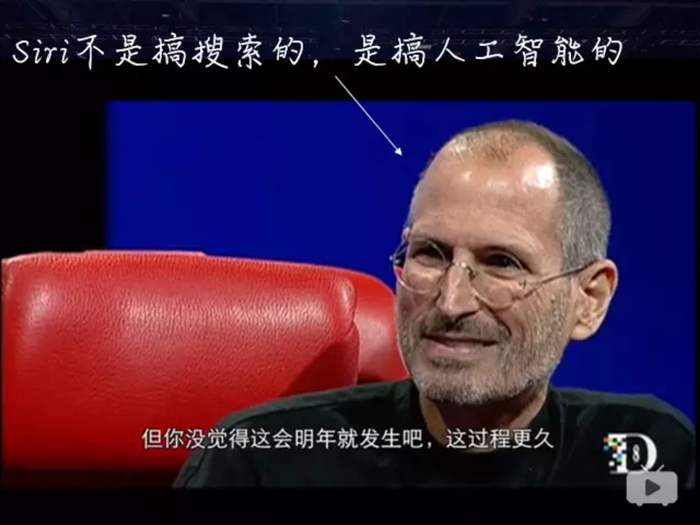

不用怀疑,乔帮主已经正面回答过了。

乔布斯在 D8 访谈中被问及苹果收购 Siri 的原因是否是想与谷歌竞争搜索业务时答曰:他们(指 Siri)不是搞搜索的,他们是搞人工智能的。

乔布斯在 D8 访谈(生前最后一次访谈)

在2018WWDC发布会上,Siri正在发生改变。

依然是库克站台

场景①

苹果Siri 增加了Shortcuts 快捷键的功能。

如果你说“Siri,我把钥匙弄丢了”,它就能通过像Tile这样的应用程序找到钥匙。

场景②

Siri可能知道你上班迟到了,因为它知道你通常会在周三早上8点离开家,它还知道你在上午9点开会。

在这种情况下,Siri可能会建议你打电话给老板,让他们知道你快迟到了。

Siri不再致力于变得“更聪明”,即回答更复杂的问题、与人类进行更自然的对话;

而是开始更多地了解我们如何使用iPhone、如何生活,然后提出建议。

很高兴,乔帮主8年前布局的AI语音识别,库克终于捡起来了。

Siri是语音识别和语义识别的结合

Siri是语音识别和语义识别的结合。

什么是语音识别?

语音识别是把声音信号转化为文字。

语音识别

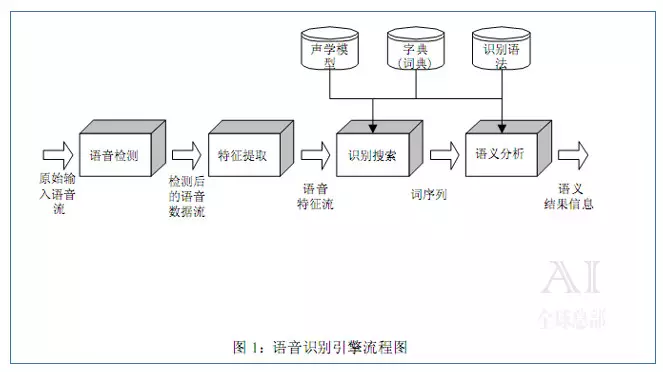

语音识别的原理

语音识别是由语言模型和声学模型构成的

一套完整的语音识别系统其工作过程分为七步:

①对语音信号进行分析和处理,除去冗余信息。

②提取影响语音识别的关键信息和表达语言含义的特征信息。

③紧扣特征信息,用最小单元识别字词。

④按照不同语言的各自语法,依照先后次序识别字词。

⑤把前后意思当作辅助识别条件,有利于分析和识别。

⑥按照语义分析,给关键信息划分段落,取出所识别出的字词并连接起来,同时根据语句意思调整句子构成。

⑦结合语义,仔细分析上下文的相互联系,对当前正在处理的语句进行适当修正。

什么是语义识别?

语义识别就是试图理解这些转化好的文字。

语义识别

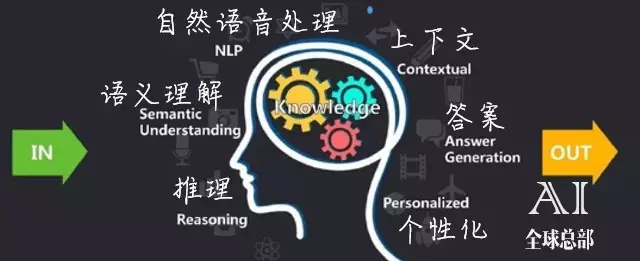

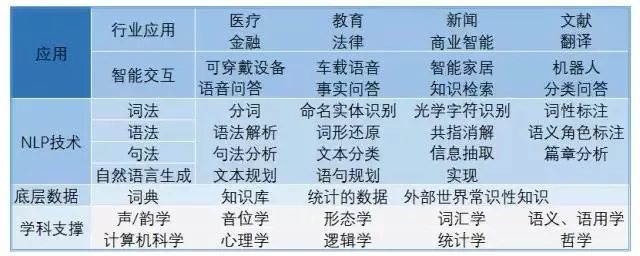

语义识别可以分为三层:

①应用层

②NLP技术层

③底层数据层

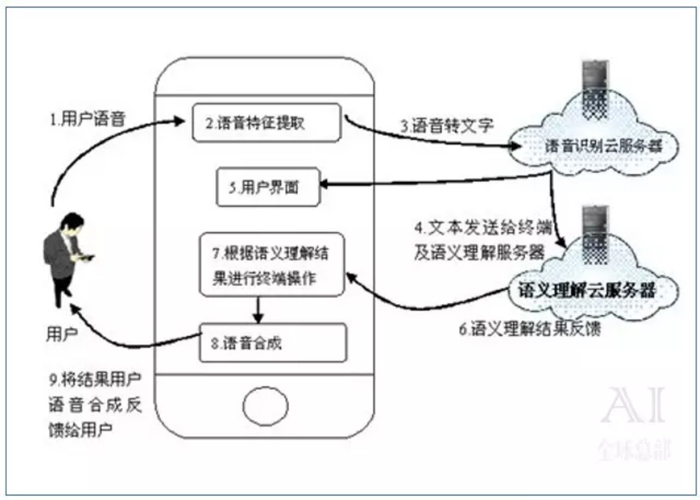

语义识别的原理

智能语音技术原理中,用户语音首先被语音识别➜转换为文字➜发送至云端服务器➜对文字进行语义和语法的识别判断。

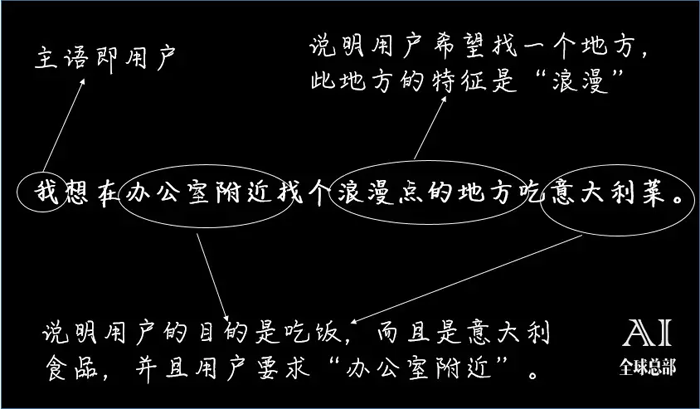

以“我想在办公室附近找个浪漫点的地方吃意大利菜”为例,智能语音技术在获得文本后,根据其语法模型进行语法分析。

得出此为一个“主语+谓语+宾语+副词”的句法结构。

根据这些关键信息,智能语音技术按照算法,判断用户可能是在寻找一个在自己附近的浪漫的意大利餐厅。

之后,利用服务提供商的搜索引擎搜索,并将结果的文字按照语法进行整合,形成回答。

应用二:用机器学习管理照片

另外,苹果提升了应用程序的机器学习搜索功能。

苹果提供了相片的搜索功能,同时还会提供搜索建议,并按时间和地点对事件进行分类,突出重点。

例如关键时刻或对你很重要的人、地方和类别,照片中有一个新的 For You 标签,会提供精选照片效果建议。

可能受Face Book数据泄露事件的影响,苹果强调实现这样的操作有一个重大前提:当你使用它们时,公司不会看到你的任何内容。